Hinweis: Dieser Beitrag wurde von den Referent:innen des Workshops Partizipatorische Datenethik verfasst. Die Anmeldung zum Workshop ist geöffnet und hier möglich.

Problembeschreibung

Tagtäglich werden durch die zunehmende Digitalisierung Daten erhoben und verarbeitet, so auch in der öffentlichen Verwaltung. Mit der (auch automatisierten) Datenerhebung können innovative Analyseprozesse vorgenommen werden, wie z.B. in der Gemeinde Zaanstad in den Niederlanden, um vorherzusagen, wann welches Haus mit Holzfundament repariert werden muss; oder wie in der Gemeinde Amersfoort, wo ein Algorithmus errechnet, an welchen Stellen der Straßenbelag durch Wurzeldruck der umstehenden Bäume beschädigt werden wird.

Was ist aber, wenn die Datensammlung und Analyse oder auch die darauf basierte Entscheidungsfindung, Werte verletzt, die für die offene Gesellschaft und unsere Demokratie wichtig sind?

Genau hier setzt die Datenethik an. Sie evaluiert inwiefern unser Umgang mit Daten, Werte transportiert und diese tangiert oder verstärkt. Sie fragt nicht, was wir mit den Daten machen dürfen, sondern was wir damit machen wollen, oder lieber unterlassen sollten. Bei allen Datenprojekten spielen Werte wie Privatsphäre, Autonomie, Gleichheit, Transparenz und andere eine Rolle. Es muss abgewogen werden, inwiefern diese Werte durch das Design und die Anwendung betroffen sind. Datenethik betrachtet KI, Daten- oder Digitalisierungsprojekte durch die Lupe des Wertesystems. So kann das ganze Projekt in seinen unterschiedlichen Aspekten evaluiert werden und können konkrete Lösungen entwickelt werden, um Fehler zu vermeiden. Um sich dieser Wertefragen bewusst zu werden, kann der Ethische Daten Assistent (DEDA) helfen.

Dialogische Deliberation von KI- und Datenprojekten

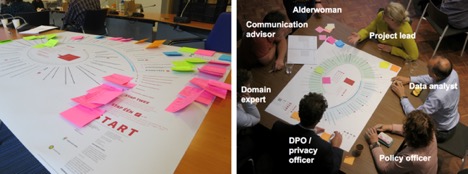

Inzwischen gibt es zahlreiche Manifeste und Richtlinien zur Anwendung von künstlicher Intelligenz und zur Nutzung von Daten. Die Organisation AlgorithmWatch hat 173 solcher Richtlinien erfasst und kategorisiert.[1] Am bekanntesten ist die der ‚EU High Level Expert Group on AI‘, die sieben Kernwerte zur Berücksichtigung vorschreibt.[2] Viele dieser Richtlinien formulieren eine Reihe von Kernwerten, die die Nutzung von Daten und die Entwicklung von KI leiten sollen. Diese Ansätze werden auch kritisch bewertet. So wird von einigen Expert:innen das datenethische Manifest der Stadt Amsterdam als zu wenig konkret angesehen. Unser Folgeabschätzungs-Instrument verfolgt einen anderen Ansatz. Es macht im dialogischen Prozess die Werte der Organisation und die Werte, die durch ein Daten- oder KI-Projekt tangiert werden, explizit. Dieser Reflexionsprozess verbindet Mitarbeiter:innen unterschiedlicher Abteilungen mit Interessenvertreter:innen oder Bürger:innen. Dadurch wird die Partizipation gesteigert und viele Teilnehmer:innen inkludiert. Darüber hinaus trägt der Prozess zu einer Steigerung des daten-ethischen Bewusstseins bei und sensibilisiert die Teilnehmer:innen für die Probleme, die aus der Erhebung, Analyse und Nutzung von Daten folgen können. Der effektivste Aspekt an diesem Ansatz ist allerdings, dass es möglich wird, das Design von Daten- und KI-Projekten hinsichtlich der Werte anzupassen und Verantwortlichkeiten herzustellen. Als Beispiel dient eine niederländische Landesregierung (Provincie), die sich auf Basis eines DEDA Assessments darauf einigte, Daten für das Besuchsaufkommen in Naherholungsgebieten nicht durch WiFi-Tracking zu erheben, sondern ausschließlich durch die von Sensoren erfasste Anzahl an Kraftfahrzeugen und Fahrrädern zu schätzen. In einem anderen Fall – der Vorhersage von „Problemadressen“ – führte es dazu, dass Mitarbeiter:innen der Nachbarschafts-Teams, Polizist:innen und Sozialhilfe-Mitarbeiter:innen den erhobenen Datenbestand korrigierten und dadurch die Zahl der angezeigten möglichen Problemadressen drastisch reduzierten.

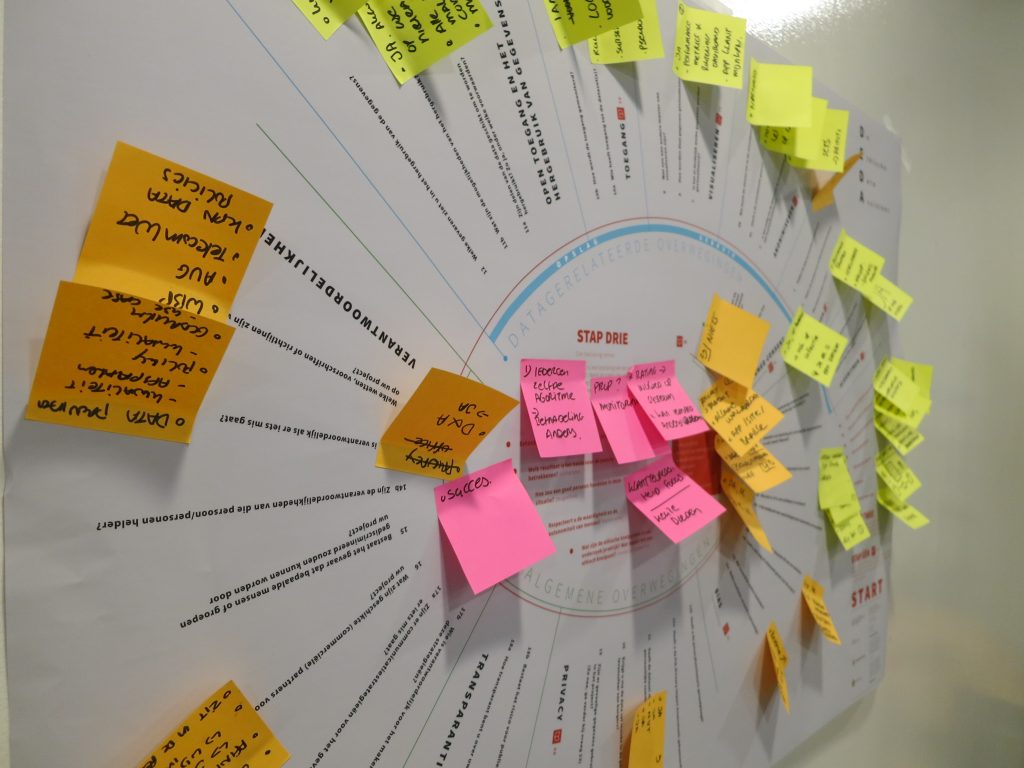

Diese ethische und partizipative Folgeabschätzung ergänzt die üblichen Data Protection Impact Assessments. DEDA stellt nicht die Frage, was bei einem KI, Daten- oder Digitalisierungsprojekt erlaubt ist, sondern fragt, was gesellschaftlich wünschenswert und verantwortbar ist. Der Prozess an sich ist reflexiv und Partizipation ist erwünscht. DEDA besteht aus einem Poster, einem Handbuch und einem Workshop, welcher auch als Online-Version zur Verfügung steht. Dieser findet in einer Videokonferenz statt und wird von einem Moderator oder einer Moderatorin begleitet. Gemeinsam kann dann das geplante Datenprojekt anhand eines Tools unter dem Aspekt der Datenethik betrachtet werden. In dem Workshop werden die Werte der Organisation und die persönlichen Werte der Teilnehmer:innen bestimmt und durch Reflektion wird versucht, das Projekt hinsichtlich seiner ethischen Dimensionen zu evaluieren und zu verstehen.

Andere Möglichkeiten der Partizipation und Deliberation

Viele Gemeinderät:innen erkennen Daten- und Digitalisierungsprojekte nicht als politische Themen, sondern lediglich als technische Prozesse, bei denen Spezialist:innen Entscheidungen treffen sollen. Es fehlt an technischer Kompetenz, aber vor allem am Bewusstsein für die gesellschaftstransformierenden Folgen der Digitalisierung. Um diesen, für den deliberativen Prozess wichtigen, Teilnehmer:innen, mehr Möglichkeiten für eine informierte Meinungsbildung zu bieten, hat die Utrecht Data School ein weiteres Instrument entwickelt. Der Digitale Ratgeber [im niederländischen Original: digitale raadgever] ist eine Art ‘Spickzettel’ um Gemeinderät:innen mögliche kritische Fragen zu einem Daten- oder Digitalisierungsprojekt anzubieten. Die Fragen leiten zu einer gründlichen Informationssammlung hinsichtlich des vorliegenden Dossiers. Im folgenden Schritt können die Nutzer:innen die möglichen politischen Dimensionen erörtern, die sich aus dem vorliegenden Projekt ergeben. Dies bietet die Grundlage, um abschließend ein Werturteil zu fällen und eine informierte Entscheidung hinsichtlich des Projekts zu nehmen.[3]

Die direkte Zusammenarbeit in Forschungsprojekten mit Organisationen der öffentlichen Verwaltung führt für die Forscher:innen zu einer weitreichenden Beteiligung am Prozess der digitalen Transformation. Nicht nur sind unsere Mitarbeiter:innen häufig als Dozent:innen oder DEDA-Trainer:innen bei diesen Organisationen zu finden, auch nehmen deren Angestellte am universitären Unterricht teil. Darüber hinaus erarbeiten die Forscher:innen zahlreiche Instrumente für verschiedene Organisationen in der öffentlichen Verwaltung, so unter anderem einen Kodex für gute digitale Verwaltung, Richtlinien zum Einsatz von Algorithmen in Kommunen, und eine Folgenabschätzung für Algorithmen und Menschenrechte für das Innenministerium. Auch werden die oben genannten Instrumente, sowie auch die Ergebnisse der Forschungsarbeit in den Berichten und Dokumenten der Regierungsorganisationen aufgegriffen und finden Eingang in die Praxis der öffentlichen Verwaltung.[4]

Unsere Form der „Action Research“ ist nicht nur partizipative Observation, sondern bietet auch den verschiedenen Teilnehmer:innen in dem untersuchten gesellschaftlichen Bereichen effektiv Möglichkeiten, um an Design- und Organisationsprozessen gestalterisch teilzunehmen.

Das Thema der Datenethik gewinnt mehr und mehr an Bedeutung, ist aber trotz Datenethik-Kommissionen und anderen kleineren Initiativen bisher noch nicht präsent genug. Um die fortschreitende Digitalisierung von Anfang an richtig anzugehen, kann die Datenethik einen entscheidenden Beitrag leisten. Das datenethische Bewusstsein in der Gesellschaft muss gesteigert werden.

[1] Algorithm Watch. 2019: AI Ethics Guidelines Global Inventory: Online.

[2] High-Level Expert Group on AI. 2019. Ethics guidelines for trustworthy AI. European Commission: Online.

[3] De digitale raadgever ist in Zusammenarbeit mit der Gemeinde Almere und der Universität Utrecht entwickelt; die niederländische Version ist online hier zu finden.

[4] Siehe z.B. den jüngsten Bericht des Raad voor Openbaar Bestuur: ROB. 2021. Sturen of gestuurd worden. Over de legitimiteit van sturen met data: Online.

Titelbild: DEDA-Poster | Dataschool.nl.